JVM-4.内存模型

内存模型

1. java 内存模型

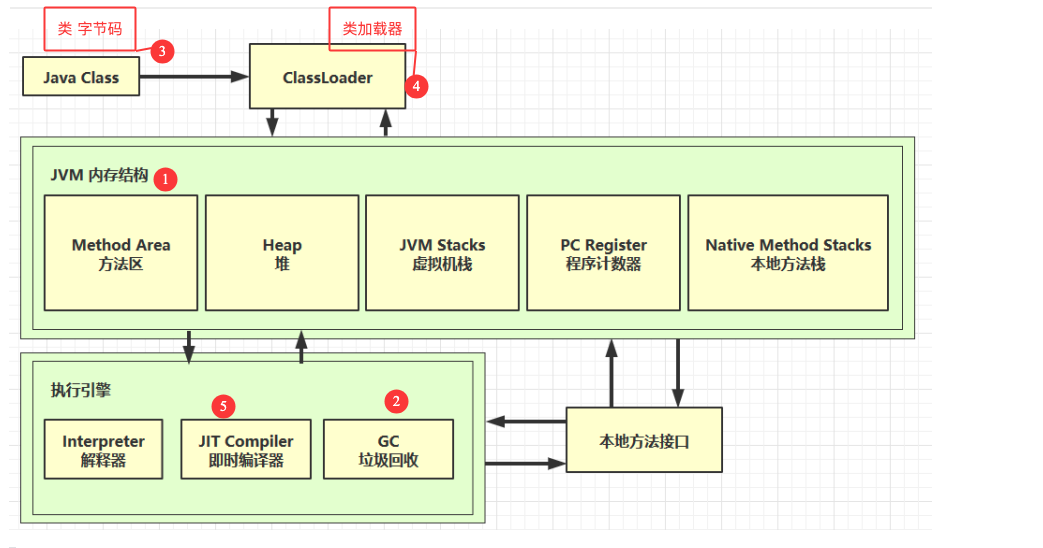

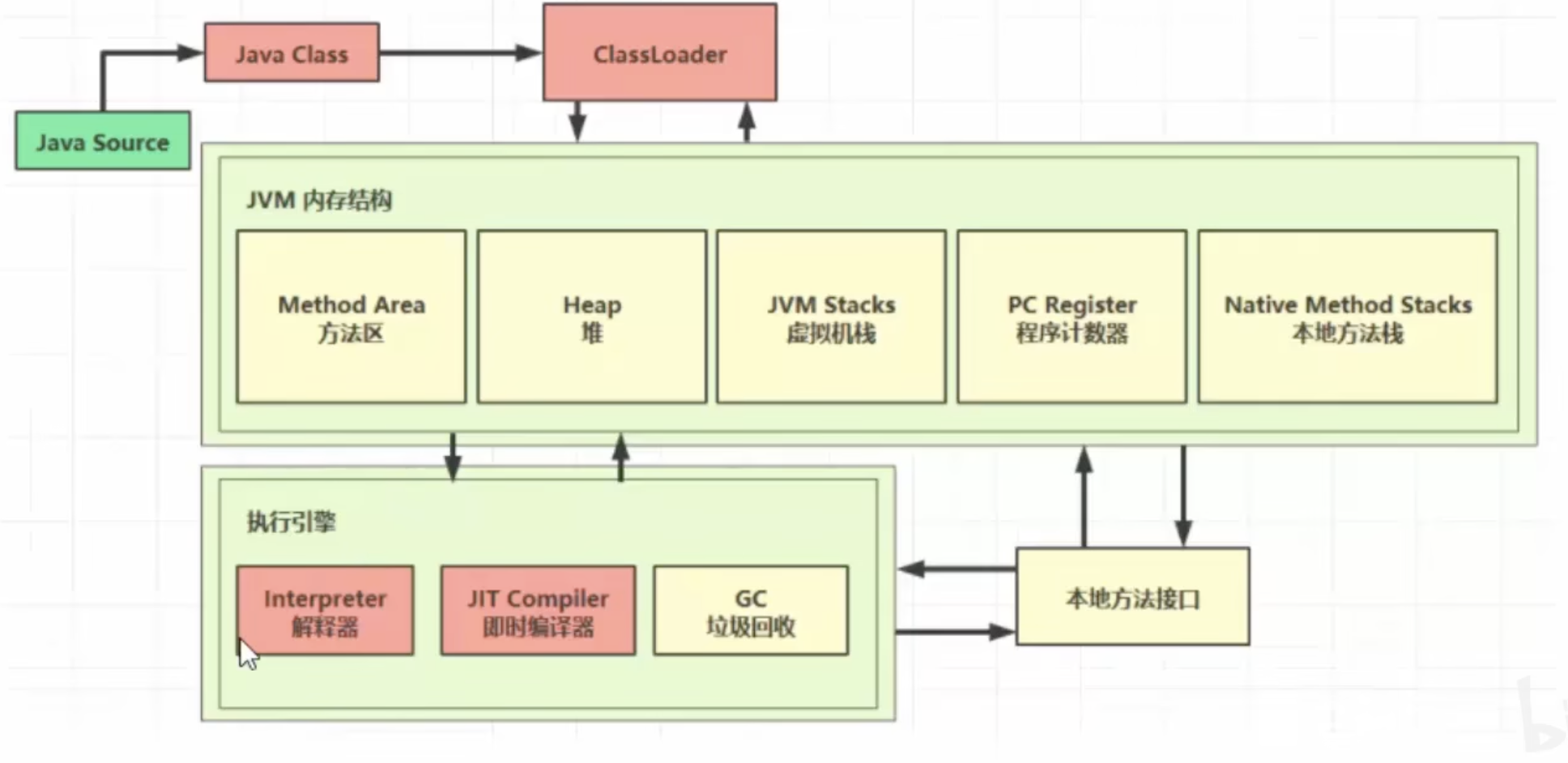

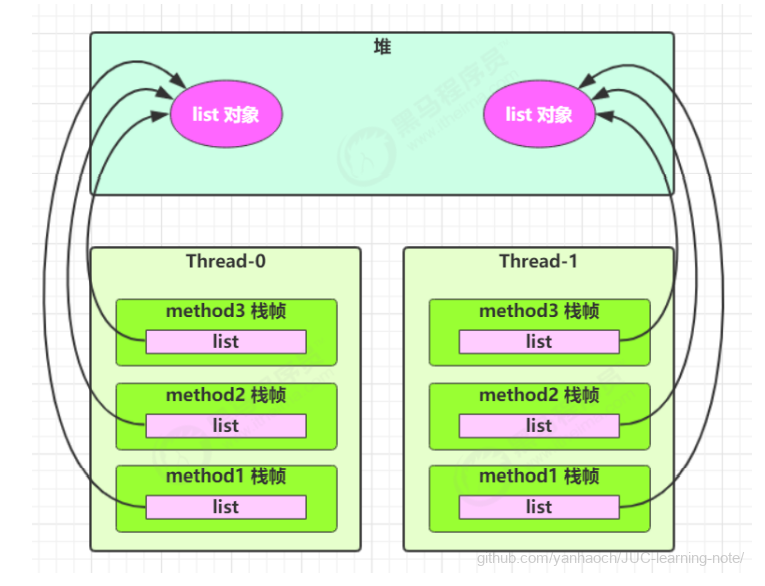

很多人将【java 内存结构】与【java 内存模型】傻傻分不清,【java 内存模型】是 Java Memory Model(JMM)的意思。

简单的说,JMM 定义了一套在多线程读写共享数据时(成员变量、数组)时,对数据的可见性、有序 性、和原子性的规则和保障

1.1 原子性

原子性在学习线程时讲过,下面来个例子简单回顾一下:

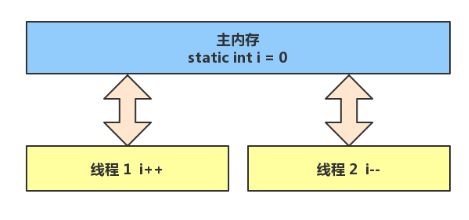

问题提出,两个线程对初始值为 0 的静态变量一个做自增,一个做自减,各做 5000 次,结果是 0 吗?

1.2 问题分析

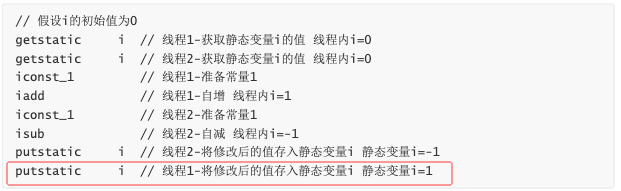

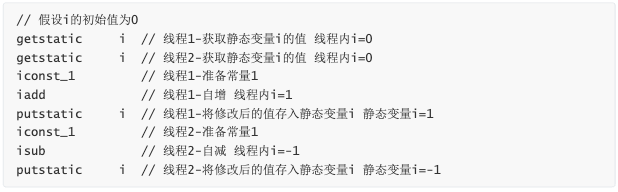

以上的结果可能是正数、负数、零。为什么呢?因为 Java 中对静态变量的自增,自减并不是原子操 作。

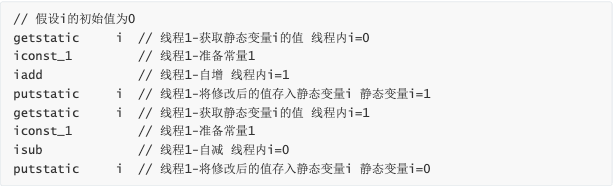

- 例如对于 i++ 而言(i 为静态变量),实际会产生如下的 JVM 字节码指令:

1 | getstatic i // 获取静态变量i的值 |

- 而对应 i– 也是类似:

1 | getstatic i // 获取静态变量i的值 |

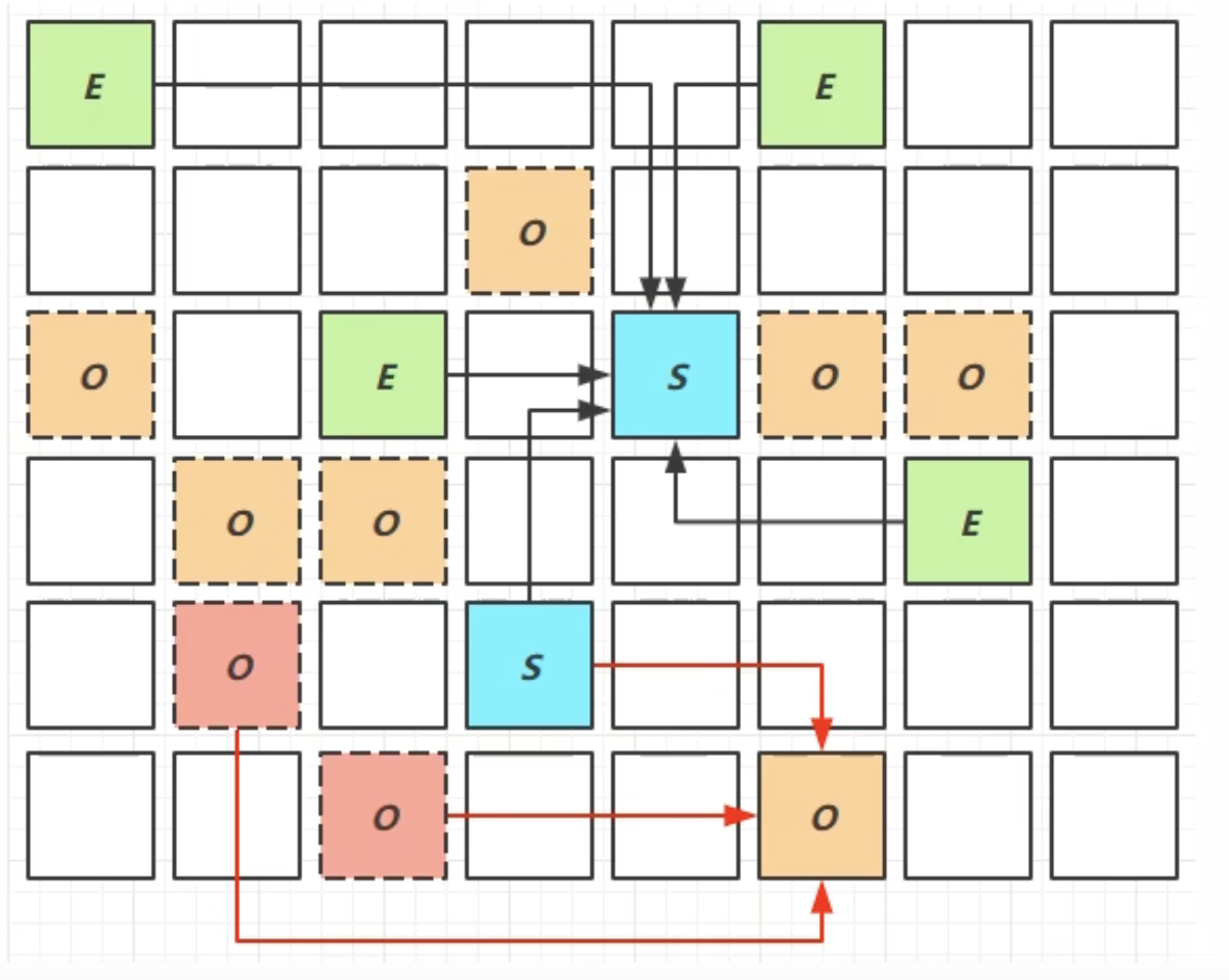

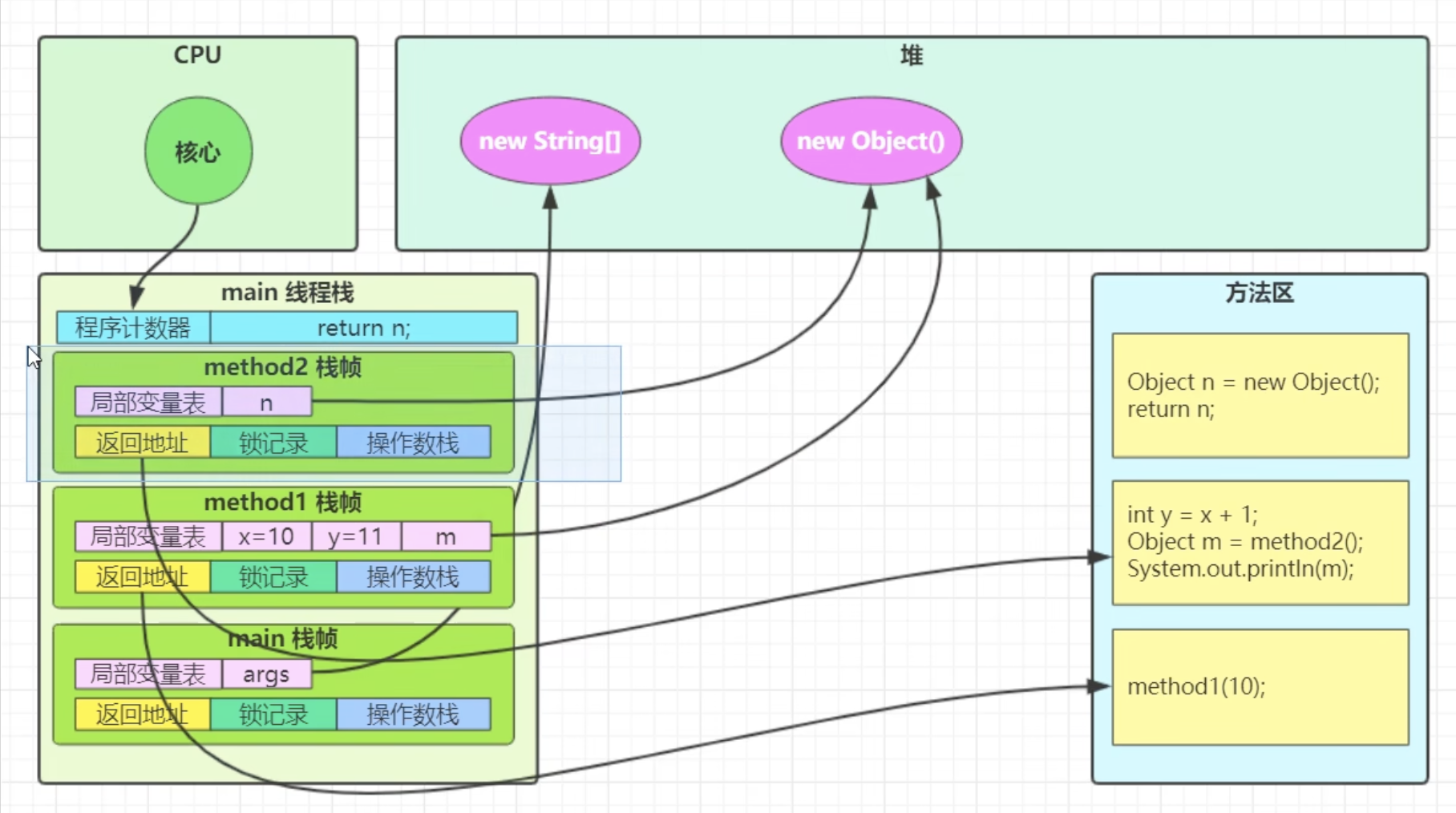

而 Java 的内存模型如下,完成静态变量的自增,自减需要在

主存和线程内存中进行数据交换:

如果是单线程以上 8 行代码是顺序执行(不会交错)没有问题:

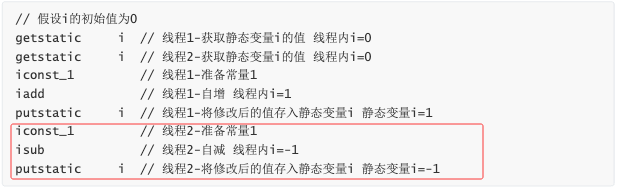

但多线程下这 8 行代码可能交错运行(为什么会交错?思考一下): 出现负数的情况

出现正数的情况

1.3 解决方法

synchronized(同步关键字)- 语法:

1 | synchronized( 对象 ) { |

- 用 synchronized 解决并发问题:

1 | public class Demo4_1 { |

- 如何理解呢:你可以把 obj 想象成一个房间,线程 t1,t2 想象成两个人。

- 当线程 t1 执行到

synchronized(obj)时就好比 t1 进入了这个房间,并反手锁住了门,在门内执行 count++ 代码。 - 这时候如果 t2 也运行到了

synchronized(obj)时,它发现门被锁住了,只能在门外等待。 - 当 t1 执行完

synchronized{}块内的代码,这时候才会解开门上的锁,从 obj 房间出来。t2 线程这时才 可以进入 obj 房间,反锁住门,执行它的 count– 代码。注意:上例中 t1 和 t2 线程必须用 synchronized 锁住同一个 obj 对象,如果 t1 锁住的是 m1 对 象,t2 锁住的是 m2 对象,就好比两个人分别进入了两个不同的房间,没法起到同步的效果。

2. 可见性

2.1 退不出的循环

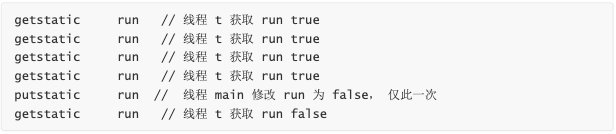

- 先来看一个现象,main 线程对 run 变量的修改对于 t 线程不可见,导致了 t 线程无法停止:

1 | public class Demo4_2 { |

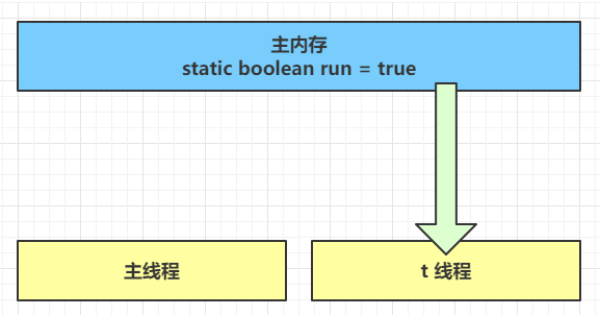

为什么呢?分析一下:

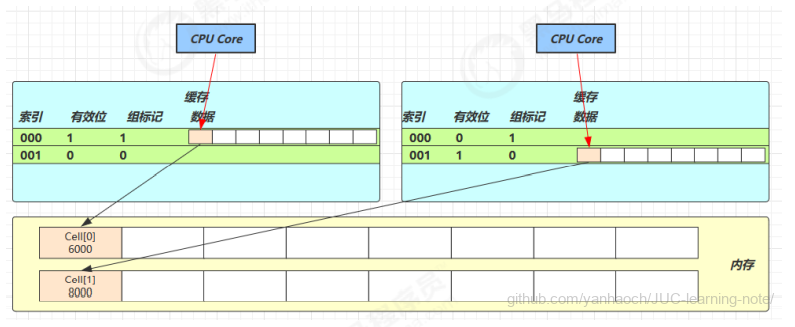

- 初始状态, t 线程刚开始从主内存读取了 run 的值到工作内存。

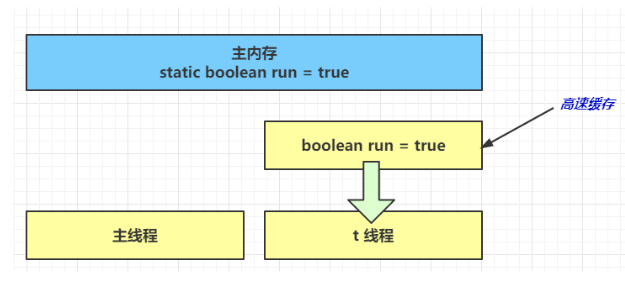

- 因为 t 线程要频繁从主内存中读取 run 的值,JIT 编译器会将 run 的值缓存至自己工作内存中的高 速缓存中,减少对主存中 run 的访问,提高效率

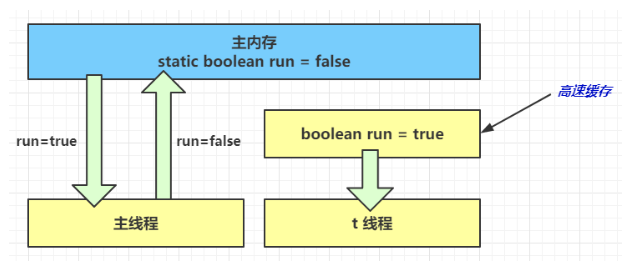

- 1 秒之后,main 线程修改了 run 的值,并同步至主存,而 t 是从自己工作内存中的高速缓存中读 取这个变量的值,结果永远是旧值

2.2 解决方法(volatile)

volatile(易变关键字)

它可以用来修饰成员变量和静态成员变量,他可以避免线程从自己的工作缓存中查找变量的值,必须到 主存中获取它的值,线程操作 volatile 变量都是直接操作主存

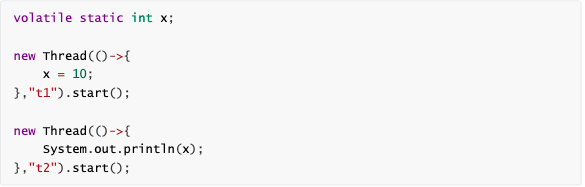

2.3 可见性

前面例子体现的实际就是可见性,它保证的是在多个线程之间,一个线程对 volatile 变量的修改对另一 个线程可见, 不能保证原子性,仅用在一个写线程,多个读线程的情况: 上例从字节码理解是这样的:

比较一下之前我们将线程安全时举的例子:两个线程一个 i++ 一个 i– ,只能保证看到最新值,不能解 决指令交错

volatile不能保证原子性

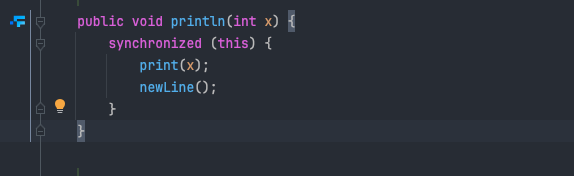

注意

synchronized 语句块既可以保证代码块的原子性,也同时保证代码块内变量的可见性。但缺点是 synchronized是属于重量级操作,性能相对更低

如果在前面示例的死循环中加入System.out.println()会发现即使不加 volatile 修饰符,线程 t 也 能正确看到对 run 变量的修改了,想一想为什么?println方法加了synchronized关键字

3. 有序性

3.1 诡异的结果

1 | int num = 0; |

- I_Result 是一个对象,有一个属性 r1 用来保存结果,问,可能的结果有几种

- 有同学这么分析

- 情况1:线程1 先执行,这时 ready = false,所以进入 else 分支结果为 1

- 情况2:线程2 先执行 num = 2,但没来得及执行 ready = true,线程1 执行,还是进入 else 分支,结 果为 1

- 情况3:线程2 执行到 ready = true,线程1 执行,这回进入 if 分支,结果为 4(因为 num 已经执行过 了)

- 但我告诉你,结果还有可能是 0 😁😁😁,信不信吧!

- 这种情况下是:线程2 执行 ready = true,切换到线程1,进入 if 分支,相加为 0,再切回线程2 执行 num = 2

- 相信很多人已经晕了 😵😵😵

- 这种现象叫做指令重排,是 JIT 编译器在运行时的一些优化,这个现象需要通过大量测试才能复现: 借助 java 并发压测工具 jcstress https://wiki.openjdk.java.net/display/CodeTools/jcstress

1 | mvn archetype:generate -DinteractiveMode=false - DarchetypeGroupId=org.openjdk.jcstress -DarchetypeArtifactId=jcstress-java-test- archetype -DgroupId=org.sample -DartifactId=test -Dversion=1.0 |

- 创建 maven 项目,提供如下测试类

1 | //@JCStressTest |

执行

1 | mvn clean install |

会输出我们感兴趣的结果,摘录其中一次结果:

1 | RUN RESULTS: |

可以看到,出现结果为 0 的情况有 10,636 次,虽然次数相对很少,但毕竟是出现了。

3.2 解决方法

volatile 修饰的变量,可以禁用指令重排volatile boolean ready = false;

1 | RUN RESULTS: |

3.3 有序性理解

JVM 会在不影响正确性的前提下,可以调整语句的执行顺序,思考下面一段代码

1 | static int i; |

- 可以看到,至于是先执行 i 还是 先执行 j ,对最终的结果不会产生影响。所以,上面代码真正执行 时,既可以是

1 | i = ...; // 较为耗时的操作 |

- 也可以是

1 | j = ...; |

- 这种特性称之为『指令重排』,多线程下『指令重排』会影响正确性,例如著名的

double-checked locking模式实现单例

1 | class Singleton { |

以上的实现特点是:

- 懒惰实例化

- 首次使用

getInstance()才使用synchronized加锁,后续使用时无需加锁

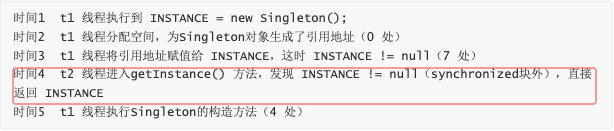

但在多线程环境下,上面的代码是有问题的,INSTANCE = new Singleton()对应的字节码为:

1 | 0: new #2 // class cn/itcast/jvm/t4/Singleton |

其中 4 7 两步的顺序不是固定的,也许 jvm 会优化为:先将引用地址赋值给 INSTANCE 变量后,再执行 构造方法,如果两个线程 t1,t2 按如下时间序列执行: 这时 t1 还未完全将构造方法执行完毕,如果在构造方法中要执行很多初始化操作,那么 t2 拿到的是将 是一个未初始化完毕的单例

这时 t1 还未完全将构造方法执行完毕,如果在构造方法中要执行很多初始化操作,那么 t2 拿到的是将 是一个未初始化完毕的单例

对 INSTANCE 使用 volatile 修饰即可,可以禁用指令重排,但要注意在 JDK 5 以上的版本的 volatile 才 会真正有效

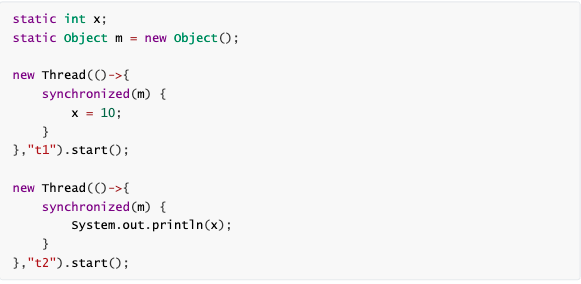

3.4 happens-before

happens-before规定了哪些写操作对其它线程的读操作可见,它是可见性与有序性的一套规则总结,- 抛开以下

happens-before规则,JMM 并不能保证一个线程对共享变量的写,对于其它线程对该共享变 量的读可见 - 线程解锁 m 之前对变量的写,对于接下来对 m 加锁的其它线程对该变量的读可见

- 线程解锁 m 之前对变量的写,对于接下来对 m 加锁的其它线程对该变量的读可见

- 线程对 volatile 变量的写,对接下来其它线程对该变量的读可见

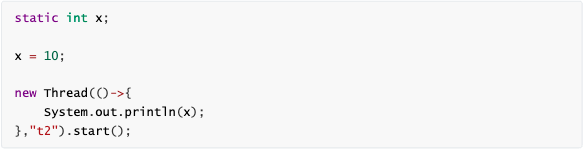

- 线程 start 前对变量的写,对该线程开始后对该变量的读可见

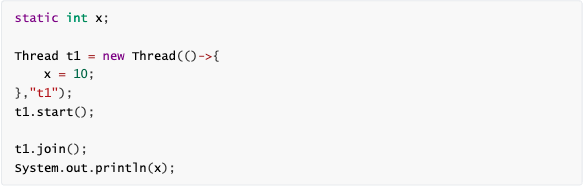

- 线程结束前对变量的写,对其它线程得知它结束后的读可见(比如其它线程调用 t1.isAlive() 或 t1.join()等待它结束)

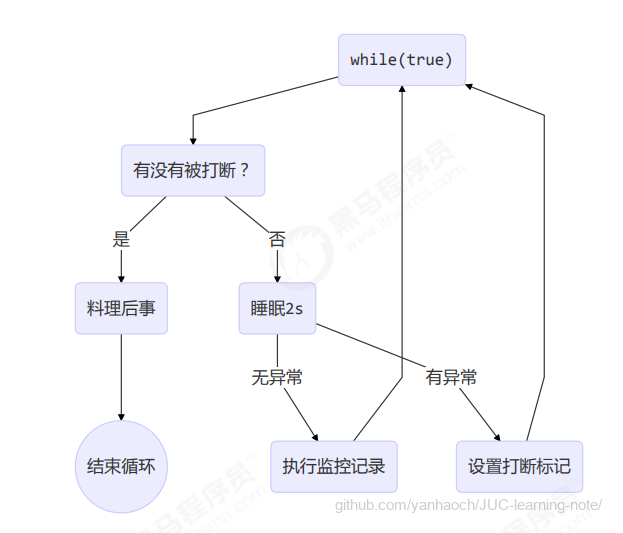

- 线程 t1 打断 t2(interrupt)前对变量的写,对于其他线程得知 t2 被打断后对变量的读可见(通 过t2.interrupted 或 t2.isInterrupted)

1 | public class Demo4_3 { |

- 对变量默认值(0,false,null)的写,对其它线程对该变量的读可见

- 具有传递性,如果

x hb-> y并且y hb-> z那么有x hb-> z(hb happens before) - 变量都是指成员变量或静态成员变量

4. CAS 与 原子类

4.1 CAS

CAS 即 Compare and Swap ,它体现的一种乐观锁的思想,比如多个线程要对一个共享的整型变量执 行 +1 操作:

- 假设共享变量是5

- 结果是6

- 在compareAndSwap中,如果其他线程将5改为10,则比较后,结果不能写入

1 | // 需要不断尝试 |

获取共享变量时,为了保证该变量的可见性,需要使用 volatile 修饰。结合 CAS 和 volatile 可以实现无 锁并发,适用于竞争不激烈、多核 CPU 的场景下。

- 因为没有使用 synchronized,所以线程不会陷入阻塞,这是效率提升的因素之一

- 但如果竞争激烈,可以想到重试必然频繁发生,反而效率会受影响

CAS 底层依赖于一个 Unsafe 类来直接调用操作系统底层的 CAS 指令,下面是直接使用 Unsafe 对象进 行线程安全保护的一个例子

1 | import sun.misc.Unsafe; |

- CAS 核心逻辑:

increase()和decrease()方法使用Unsafe.compareAndSwapInt()实现原子操作- 通过循环重试机制处理并发冲突

- 关键组件:

Unsafe:通过反射获取,提供底层 CAS 操作DATA_OFFSET:字段内存偏移量,用于精确定位data字段volatile:保证变量的可见性

- 执行流程:

- 主线程创建

DataContainer实例 - 启动线程 t1 执行 5 次增加操作

- 使用

join()等待 t1 完成 - 输出最终结果(应该是 5)

- 主线程创建

4.2 乐观锁与悲观锁

对于java而言,乐观锁介绍CAS,悲观锁就是synchronized

CAS是基于乐观锁的思想:最乐观的估计,不怕别的线程来修改共享变量,就算改了也没关系, 我吃亏点再重试呗。synchronized是基于悲观锁的思想:最悲观的估计,得防着其它线程来修改共享变量,我上了锁 你们都别想改,我改完了解开锁,你们才有机会。

4.3 原子操作类

juc(java.util.concurrent)中提供了原子操作类,可以提供线程安全的操作,例如:AtomicInteger、 AtomicBoolean等,它们底层就是采用 CAS 技术 + volatile 来实现的。

可以使用 AtomicInteger 改写之前的例子:

1 | public class Demo4_4 { |

5. synchronized 优化

Java HotSpot 虚拟机中,每个对象都有对象头(包括 class 指针和 Mark Word)。Mark Word 平时存 储这个对象的 哈希码 、 分代年龄 ,当加锁时,这些信息就根据情况被替换为 标记位 、 线程锁记录指针 、 重量级锁指针 、 线程ID 等内容

5.1 轻量级锁

如果一个对象虽然有多线程访问,但多线程访问的时间是错开的(也就是没有竞争),那么可以使用轻 量级锁来优化。这就好比:

学生(线程 A)用课本占座,上了半节课,出门了(CPU时间到),回来一看,发现课本没变,说明没 有竞争,继续上他的课。

如果这期间有其它学生(线程 B)来了,会告知(线程A)有并发访问,线程 A 随即升级为重量级锁, 进入重量级锁的流程。

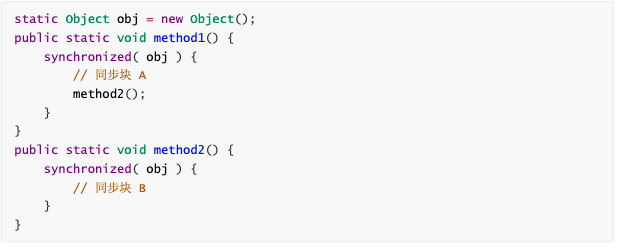

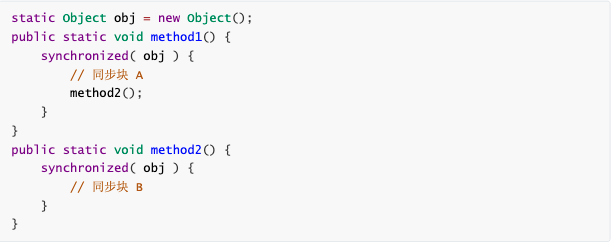

而重量级锁就不是那么用课本占座那么简单了,可以想象线程 A 走之前,把座位用一个铁栅栏围起来 假设有两个方法同步块,利用同一个对象加锁

每个线程都的栈帧都会包含一个锁记录的结构,内部可以存储锁定对象的 Mark Word

5.2 锁膨胀

如果在尝试加轻量级锁的过程中,CAS 操作无法成功,这时一种情况就是有其它线程为此对象加上了轻 量级锁(有竞争),这时需要进行锁膨胀,将轻量级锁变为重量级锁。

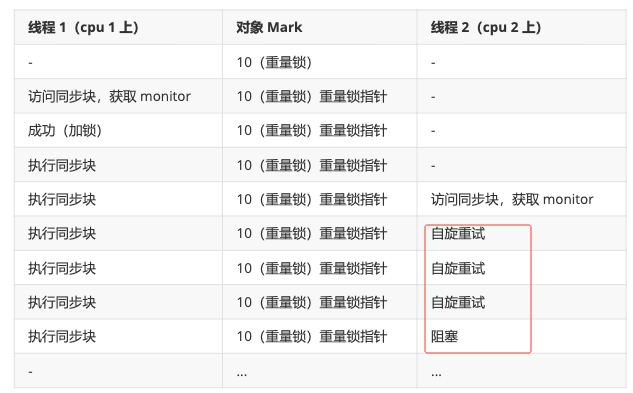

5.3 重量锁

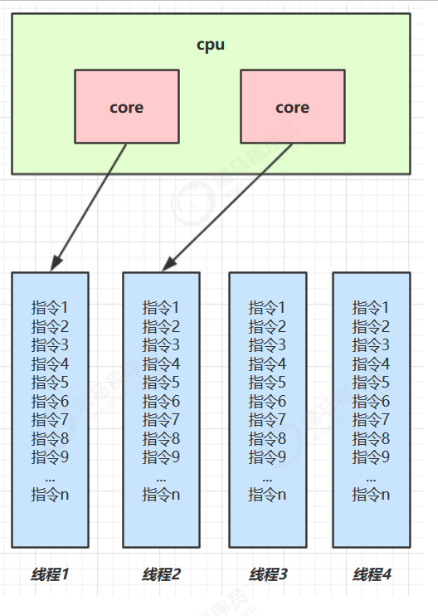

重量级锁竞争的时候,还可以使用自旋来进行优化,如果当前线程自旋成功(即这时候持锁线程已经退 出了同步块,释放了锁),这时当前线程就可以避免阻塞。 在 Java 6

在 Java 6 之后自旋锁是自适应的,比如对象刚刚的一次自旋操作成功过,那么认为这次自旋成功的可能 性会高,就多自旋几次;反之,就少自旋甚至不自旋,总之,比较智能。

- 自旋会占用 CPU 时间,单核 CPU 自旋就是浪费,多核 CPU 自旋才能发挥优势。

- 好比等红灯时汽车是不是熄火,

不熄火相当于自旋(等待时间短了划算),熄火了相当于阻塞(等 待时间长了划算) - Java 7 之后不能控制是否开启自旋功能

自旋重试成功的情况

自旋重试失败的情况

5.4 偏向锁

轻量级锁在没有竞争时(就自己这个线程),每次重入仍然需要执行 CAS 操作。Java 6 中引入了偏向锁 来做进一步优化:只有第一次使用 CAS 将线程 ID 设置到对象的 Mark Word 头,之后发现这个线程 ID 是自己的就表示没有竞争,不用重新 CAS.

- 撤销偏向需要将持锁线程升级为轻量级锁,这个过程中所有线程需要暂停(STW)

- 访问对象的 hashCode 也会撤销偏向锁

- 如果对象虽然被多个线程访问,但没有竞争,这时偏向了线程 T1 的对象仍有机会重新偏向 T2,

- 撤销偏向和重偏向都是批量进行的,以类为单位

- 如果撤销偏向到达某个阈值,整个类的所有对象都会变为不可偏向的

- 可以主动使用

-XX:-UseBiasedLocking禁用偏向锁 - 参考论文:

- https://www.oracle.com/technetwork/java/biasedlocking-oopsla2006-wp-149958.pdf

假设有两个方法同步块,利用同一个对象加锁

5.5 其它优化

1. 减少上锁时间

同步代码块中尽量短

2. 减少锁的粒度

将一个锁拆分为多个锁提高并发度,例如:

ConcurrentHashMapLongAdder分为 base 和 cells 两部分。没有并发争用的时候或者是 cells 数组正在初始化的时 候,会使用 CAS 来累加值到 base,有并发争用,会初始化 cells 数组,数组有多少个 cell,就允 许有多少线程并行修改,最后将数组中每个 cell 累加,再加上 base 就是最终的值LinkedBlockingQueue入队和出队使用不同的锁,相对于LinkedBlockingArray只有一个锁效率要 高

3. 锁粗化

多次循环进入同步块不如同步块内多次循环

另外 JVM 可能会做如下优化,把多次 append 的加锁操作粗化为一次(因为都是对同一个对象加锁, 没必要重入多次)

1 | new StringBuffer().append("a").append("b").append("c"); |

4. 锁消除

JVM 会进行代码的逃逸分析,例如某个加锁对象是方法内局部变量,不会被其它线程所访问到,这时候 就会被即时编译器忽略掉所有同步操作。

5. 读写分离

- CopyOnWriteArrayList

- ConyOnWriteSet

参考:

https://wiki.openjdk.org/display/HotSpot/Synchronization

http://luojinping.com/2015/07/09/java%E9%94%81%E4%BC%98%E5%8C%96/

https://www.infoq.cn/article/java-se-16-synchronized

https://www.jianshu.com/p/9932047a89be

https://www.cnblogs.com/sheeva/p/6366782.html

https://stackoverflow.com/questions/46312817/does-java-ever-rebias-an-individual-lock